Artificial Intelligence Act, ecco la disciplina dell’Unione Europea

L’accordo raggiunto da Parlamento e Consiglio Europeo segna l’inizio della prima normativa al mondo in materia di intelligenza artificiale: previsti divieti di utilizzo per la sicurezza dei cittadini, una differenziazione dei rischi previsti e una spiccata attenzione alla protezione dei diritti individuali

13/02/2024

L’8 dicembre il Parlamento e il Consiglio europeo hanno finalmente raggiunto un accordo per promulgare l’Artificial Intelligence Act, la prima normativa al mondo in materia di intelligenza artificiale (IA). La disposizione entrerà in vigore progressivamente nell’arco di due anni. Con essa viene stabilita una disciplina completa e solida che guiderà l’uso di questo strumento, del quale ormai si parla ovunque e in tutti i contesti, prevedendo gli obblighi che ne guideranno l’uso. Il testo è frutto di più di due anni di lavoro e di lunghi negoziati, che hanno consentito all’Unione Europea di raggiungere una pionieristica legislazione sull’IA, la più completa e organica al mondo, con l’obiettivo di coniugarne lo sviluppo con il rispetto dei diritti fondamentali dei cittadini, nello sforzo di far coesistere sicurezza e libertà sulla frontiera più avanzata dell’hi-tech.

Si tratta di un provvedimento normativo molto atteso: come sappiamo, l’ascesa degli strumenti offerti dall’IA generativa ha portato sotto i riflettori le sfide che il suo utilizzo può comportare in tutti i settori. In ambito assicurativo, ad esempio, The Geneva Association si è più volte espressa riguardo alle problematiche connesse all’eventualità che si verifichino discriminazioni e pregiudizi ai danni dei fruitori dei prodotti assicurativi, quando l’IA fosse utilizzata in modo incontrollato.

DIVIETI PER LA SICUREZZA DEL CITTADINO

Sulla scia delle indicazioni fornite dagli esperti, l’Artificial Intelligence Act prevede quindi una serie di divieti indirizzati a renderne più sicuro l’utilizzo, come quelli sulla categorizzazione biometrica che utilizza dati sensibili (quali il credo politico o religioso, il pensiero filosofico, l’orientamento sessuale o l’etnia), la raccolta non mirata di immagini del volto (da internet o da filmati di telecamere a circuito chiuso) per creare database di riconoscimento facciale, i sistemi di riconoscimento delle emozioni sul luogo di lavoro e nelle scuole e quelli di classificazione sociale, basati sui comportamenti o sulle caratteristiche personali. In genere, verranno vietati i sistemi di IA che manipolano il comportamento umano per influenzarne le decisioni o che siano utilizzati per sfruttare le vulnerabilità delle persone (per esempio, a causa della loro età, disabilità, situazione sociale o economica).

Alcune eccezioni ai divieti sopravviveranno per l’uso di sistemi di identificazione biometrica in spazi accessibili al pubblico, qualora vi fosse un’autorizzazione dell’autorità giudiziaria e per alcuni reati specifici. Tali sistemi di identificazione biometrica avanzata (Rbi) dovranno essere utilizzati esclusivamente per la ricerca mirata di una persona condannata o sospettata di aver commesso un reato grave. Essi dovranno rispettare alcuni requisiti e il loro uso dovrà essere limitato nel tempo e nello spazio, ad esempio allo scopo di ricercare vittime di reati di rapimento, oppure di crimini sessuali. Allo stesso modo, ne verrà autorizzato l’uso per la localizzazione e l’identificazione di persone sospettate di aver commesso reati gravi (elencati nel regolamento), come terrorismo, traffico di esseri umani, sfruttamento sessuale, omicidio, rapimento, stupro, rapina a mano armata, partecipazione a un’organizzazione criminale e reati ambientali. Muovendosi sulle stesse linee già applicate con successo sul Gdpr e sulla normativa per la salvaguardia dell’ambiente, l’Unione ha scelto di muoversi con un approccio risk based, in quanto un metodo proporzionato al rischio consentirà di agganciare la normativa alla crescita del sistema, specialmente in questa materia, caratterizzata da un’evoluzione pressoché continua.

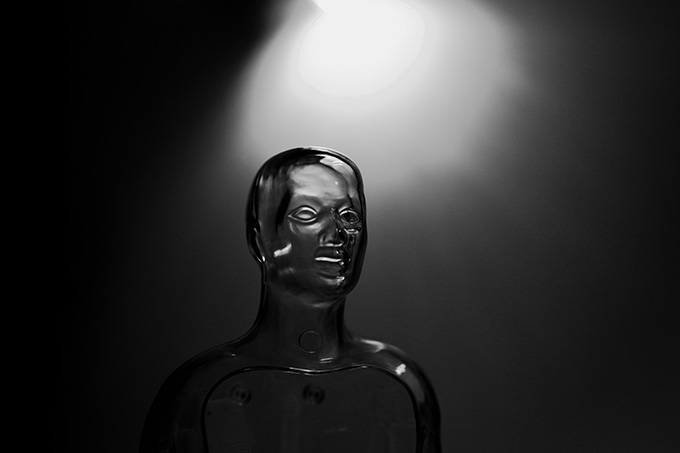

© pavel danilyuk – pexels

DIFFERENZIAZIONE DEI RISCHI PREVISTI E SANZIONI PECUNIARIE

L’accordo prevede una differenziazione dei sistemi di IA in base al tipo di rischio che implicano, ed è piuttosto articolato. I sistemi riconosciuti come ad alto rischio, ad esempio quelli utilizzati nei settori finanziari, ovvero in ambito assicurativo e bancario, dovranno essere obbligatoriamente soggetti a una valutazione dell’impatto che potranno avere sui diritti fondamentali dei cittadini. Dovrà quindi essere salvaguardato per quest’ultimi il diritto di reclamo, proprio per poter comprendere appieno come eventuali decisioni, basate su tali sistemi, potranno impattare sui loro diritti. I sistemi di IA utilizzati per scopi generali ad alto rischio sistemico dovranno aderire ai requisiti di trasparenza proposti dal Parlamento Europeo, prevedendo la stesura di una documentazione tecnica, il rispetto della legge sul diritto d’autore e l’indicazione dettagliata dei contenuti utilizzati per la loro creazione.

Bisognerà riferire alla Commissione Europea eventuali incidenti registrati, garantire la sicurezza informatica dei sistemi adottati e riferire sulla loro efficienza energetica. Il mancato rispetto delle norme dell’accordo comporterà sanzioni pecuniarie alquanto cospicue, che vanno da 7,5 milioni di euro (o l’1,5% del fatturato), fino a 35 milioni di euro (o il 7% del fatturato globale), a seconda della violazione e delle dimensioni dell’azienda, anche se saranno previste sanzioni più lievi per le piccole imprese e le start up.

PROTEZIONE DEI DIRITTI INDIVIDUALI NELL’USO DEGLI STRUMENTI TECNOLOGICI

Ci vorrà ancora del tempo, prima della ratifica finale da parte del Consiglio Europeo e dell’Europarlamento, ma si tratta di un passo fondamentale per la protezione dei diritti individuali dei cittadini nell’uso delle tecnologie, una posizione che Angela Merkel, a suo tempo, definì in equilibrio “fra l’eccesso di libertà negli Stati Uniti e l’assenza di libertà nella Cina popolare”. Da allora l’Unione Europea ha compiuto molti sforzi per trasferire le garanzie dello stato di diritto all’interno della realtà digitale, ma la sfida è divenuta ora più impellente, proprio grazie al debutto sul mercato dell’IA. Si rende necessario vigilare sul suo uso indiscriminato a vantaggio di persone, gruppi organizzati, aziende private o Stati, che potrebbero approfittarne per condizionare l’opinione pubblica, con la finalità di acquisire più denaro e potere. La lotta avvenuta all’interno dell’azienda americana titolare della tecnologia ChatGpt, terminata con la vittoria di chi intende accelerare sullo sviluppo dell’intelligenza artificiale, ha fatto comprendere quanto sia urgente proteggere i diritti dei cittadini, creando tutele a difesa dei consumatori e garantendo la qualità delle informazioni diffuse sul web.

In un sondaggio condotto da Swg è emerso che gli italiani riconoscono l’intelligenza artificiale come una tecnologia positiva, che va però tenuta sotto controllo.

Uno su tre pensa che per essa serva un approccio etico, allo scopo di comprendere il suo reale impatto sulla società. È quindi necessario sviluppare sistemi di sicurezza che le impediscano di prendere autonomamente decisioni che possano danneggiare l’uomo. Lo studio evidenzia quindi la crescente preoccupazione dei cittadini nei confronti dell’IA, specialmente dopo il lancio di ChatGpt, l’IA generativa capace di imitare le capacità creative dell’uomo.

© tara winstead – pexels

LA MINACCIA DEL “FAR WEST DIGITALE” IN CUI VIVIAMO

Quello intrapreso con l’Artificial Intelligence Act è un percorso indispensabile ma difficile: il regolamento europeo sulla protezione dei dati (o Gdpr), vero spartiacque per la protezione della privacy, è stato approvato nel 2016 ed è in vigore dal 2018, ma resta ancora in gran parte inapplicato nella maggioranza dei paesi europei (Italia inclusa), essenzialmente per la difficoltà di imporne il rispetto alle società che controllano il mercato dei dati. Di fronte a questo vero e proprio far west digitale, lo stato di diritto si trova in grave difficoltà. Pensiamo ai casi di bullismo, che è oggi il più diffuso reato commesso dai minori sul web, e ai femminicidi, che molti considerano agevolati dalla proliferazione di immagini su abusi e violenze sessuali. Pensiamo alle interferenze denunciate dagli esperti della Nato e dell’Unione Europea come minacce alla vita democratica, alle fake news adoperate dalle organizzazioni terroristiche per cercare di legittimare il loro operato o infine alla proliferazione di messaggi di odio razziale (antisemita, islamofobo ecc.). Tutte queste minacce mettono a rischio le libertà individuali e indeboliscono la democrazia in tutto il mondo ed è purtroppo noto come un uso indiscriminato dell’IA possa offrire terreno fertile per la loro diffusione.

Su questo campo si gioca quindi la necessità di una regolamentazione che protegga i diritti individuali, salvaguardando lo sviluppo dell’innovazione che le nuove tecnologie sono in grado di offrire all’umanità. E non è questione di voler fare i buonisti, perché in palio non c’è solo la salvaguardia della libertà dei cittadini, ma anche la nostra prosperità. Il ministro francese per il Digitale, Jean-Noël Barrot, ha sottolineato come la posta in palio sia la salvaguardia di un mercato che è stimato in trilioni di euro ed è in grado di ridefinire da solo l’intera economia globale: “Il dominio tecnologico – ha detto – precede oggi il dominio economico e quello politico”.

© RIPRODUZIONE RISERVATA